Derivasjon

| Områder i analyse |

| Differensialligninger |

| Funksjonalanalyse |

| Funksjoner av flere variable |

| Matematisk analyse |

|

Kontinuitet |

| Komplekse funksjoner |

Derivasjon er en operasjon i matematikk der en bestemmer den deriverte av en funksjon. For en funksjon av én reell variabel er den deriverte definert ved

- ,

dersom grenseverdien eksisterer. Den deriverte er et mål for endringen i funksjonsverdier når den frie variabelen endres. Geometrisk er den deriverte et uttrykk for stigningstallet til tangenten til funksjonen.

For funksjoner av flere variable kan en definere ulike typer deriverte, som retningsderivert, partiellderivert og totalderivert.

Studiet av derivasjon og differensialer kalles differensialregning. Analysens fundamentalteorem sier at derivasjon og integrasjon er inverse operasjoner, og en bruker derfor ofte betegnelsen differensial- og integralregning. Dette fagfeltet er svært viktig både for matematisk analyse og for anvendt matematikk.

Derivasjon av en reell funksjon av én variabel[rediger | rediger kilde]

En reell funksjon av én variabel er en funksjon . Et enkelt eksempel er funksjonen som beskriver en rett linje. For en rett linje er stigningstallet lik den deriverte til funksjonen som beskriver linjen.

Stigningstallet for en rett linje[rediger | rediger kilde]

En rett linje kan beskrives med funksjonen

- .

Hvis koeffisienten er lik null, så er funksjonen lineær. Koeffisienten er stigningstallet som styrer vinkelen som linjen danner med -aksen:

- .

Gitt to punkt og , så finner en stigningstallet ved

Symbolet brukes for å beskrive en endring i en størrelse, og og er samsvarende endringer:

Funksjonen som beskriver en rett linje, har derivert .

Formell definisjon av den deriverte[rediger | rediger kilde]

En funksjon som avbilder et åpent intervall av reell tall, er deriverbar i hvis den følgende grenseverdien eksisterer:

- (med )

Grenseverdien kalles den deriverte til med hensyn på i . Dersom grenseverdien ikke eksisterer, så er funksjonen ikke deriverbar i punktet. Hvis funksjonen er deriverbar i et hvert punkt i intervallet, sies funksjonen å være deriverbar i intervallet. Den deriverte definerer da en ny funksjon i intervallet, ofte skrevet som eller :

- .

Ordet «differensierbar» brukes synonymnt med «deriverbar».

Det eksisterer mange ulike skriveformer for funksjonen som er resultat av derivasjonen, drøftet i det følgende avsnittet Notasjon.

En funksjon kan være deriverbar i hele , men kan også ha punkter der den ikke er deriverbar. Det eksisterer funksjoner som ikke er deriverbare i noe punkt, for eksempel funksjonen som beskriver Koch-kurven, navngitt etter Helge von Koch.

Eksempler[rediger | rediger kilde]

Den deriverte til funksjonen i punktet kan finnes ved å forenkle differensekvotienten

Den deriverte finnes ved å ta grenseverdien når :

- .

Vanligvis finnes den deriverte av en funksjon ved hjelp av regneregler for derivasjon og ikke ved bruk av definisjonen, slik som er gjort her. Regnereglene må imidlertid bevises ved hjelp av definisjonen for den deriverte.

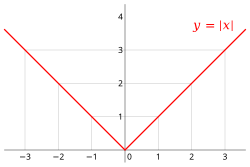

Et eksempel på en funksjon som ikke er deriverbar overalt, er gitt ved absoluttverdi-funksjonen:

For er den deriverte lik -1, mens i intervallet er den deriverte lik 1. For eksisterer de to ensidige grenseverdiene, men da disse ikke er like, så er funksjonen ikke deriverbar for dette argumentet:

- .

Et slik punkt hvor den deriverte eksisterer på begge sider, men hvor de ensidige grenseverdiene er ulike, kalles et knekkpunkt for grafen til funksjonen.

Høyere-ordens deriverte[rediger | rediger kilde]

Hvis den deriverte til funksjonen er deriverbar, kan man definere den andrederiverte eller dobbeltderiverte til som den deriverte til den førstederiverte. Denne nye funksjonen kan skrives som . Tilsvarende kan man definere den tredje deriverte , og så videre.

Den n-te deriverte kalles også den deriverte av orden n.

Ved å bruke samme eksempel som tidligere, finner en

Geometrisk tolkning[rediger | rediger kilde]

Verdien av den deriverte i et punkt generaliserer stigningskoeffisienten for en rett linje. For en vilkårlig deriverbar funksjon vil verdien av den deriverte være lik stigningskoeffisienten til tangenten til funksjonsgrafen i punktet.

For å definere tangenten starter en med en sekant gjennom to punkt på funksjonsgrafen, og . Ved å la gå mot null, som i grenseverdien som definerer den deriverte, vil sekanten nærme seg tangenten som grense.

Ligningen for tangenten i punktet er

Den andrederiverte er et mål for krumningen til grafen i et punkt. En rett linje har ingen krumning, og funksjonen har en andrederivert lik null.

Generelt har grafen til en vilkårlig funksjon en krumning gitt ved det følgende uttrykket:[1]

Aritmetisk tolkning[rediger | rediger kilde]

Den deriverte til en funksjon i punktet beskriver den lokale oppførselen til funksjonen i en omegnen om . Fra definisjonen av den deriverte følger det at

Leddet er en funksjon av både og , og leddet må gå mot null når går mot null. For en liten verdi av kan en derfor bruke tilnærmingen

Den deriverte er et mål på den lineære andelen av endringen i , når endres med et vilkårlig lite tall. En slik vilkårlig liten endring kalles en infinitesimal endring. Når tilnærmingen brukes for en endelig verdi av , omtales tilnærmingen som en linearisering av funksjonen.

Antideriverte[rediger | rediger kilde]

Antiderivasjon er prosessen for å finne en antideriverte funksjon, også kalt en primitiv funksjon. En funksjon er en primitiv funksjon til dersom funksjonen er dens deriverte, det vil si dersom .

Notasjon for deriverte[rediger | rediger kilde]

Det eksisterer flere forskjellige skriveformer for deriverte, brukt både gjennom historisk tid og i dag.

Leibniz' notasion[rediger | rediger kilde]

Symbolene , og ble introdusert av Gottfried Leibniz i 1675.[2] Denne skrivemåten er fremdeles vanlig brukt når en ønsker å understreke funksjonssammenhengen . Den første-ordens deriverte skrives som en infinitesimal brøk

- .

Høyere-ordens deriverte av orden n uttrykkes på formen

Den deriverte for et gitt argument kan med denne notasjonen skrives som

Lagranges notasjon[rediger | rediger kilde]

En svært vanlig form for symbol for den deriverte stammer fra Joseph Louis Lagrange og bruker et primtegn sammen med symbolet for funksjonen. Notasjonen ble første gang brukt i verket Theorie des fonctions analytiques i 1797.[3] Den deriverte av funksjonen symboliseres med. Høyere-ordens deriverte kan skrives ved å gjenta primtegnet, slik at den andre-deriverte er . For deriverte av orden høyere enn tre, kan en sette ordenstallet med opphøyd skrift, enten med romertall eller med vanlige tallsymbol:

- eller

Lagranges notasjon er mer praktisk enn Leibniz' når en vil understreke at den deriverte er en selvstendig funksjon.

Newtons notasjon[rediger | rediger kilde]

Newtons notasjon for å symbolisere tidsderiverte går tilbake til 1665.[4] Bruk av denne notasjonen finnes vanlig både i fysikk og matematikk. For en funksjon der argumentet representerer tid, kan en prikk over funksjonen symbolisere derivasjon. Hvis , så representerer de følgende funksjonene den førstederiverte og den andrederiverte:

- .

Prikk-notasjonen er også brukt i differensialgeometri for den deriverte med hensyn på buelengden.[5]

Eulers notasjon[rediger | rediger kilde]

Leonhard Euler forsvarte i 1755 notasjonen for den deriverte funksjonen, men dette skapte en del forvirring jevnført med Leibniz' skrivemåte.[6] I 1800 foreslo Louis François Antoine Arbogast i steden å bruke en stor bokstav for en differensialoperator som operert på funksjonen gir den første-deriverte .[7] Den n-te deriverte skrives . For å presisere hva som er den uavhengige variabelen, så kan denne skrives med nedfelt skrift: Hvis funksjonen er , så skrives da den deriverte som

- eller .

Utregning av den deriverte[rediger | rediger kilde]

Den deriverte til en gitt funksjon regnes vanligvis ut ved å kombinere

- kjennskap til deriverte for et sett av elementære funksjoner; med

- et sett av derivasjonsregler for å behandle sammensatte funksjoner.

Derivasjon av elementære funksjoner[rediger | rediger kilde]

- Konstante funksjoner

Derivasjonsregler[rediger | rediger kilde]

La , og være reelle, deriverbare funksjoner. La videre og være reelle tall. Da gjelder:

- Faktorregelen

- Summeregelen

- Produktregelen

- Kvotientregelen eller brøkregelen

- Kjerneregelen

- Kombinert kjerne og produktregel

- Inverse funksjoner

Hvis er en bijektiv funksjon som er deriverbar i med , og den inverse funksjonen er deriverbar ved , så gjelder:

- Leibniz’ regel

- .

Her er binomialkoeffisienter.

Implisitt derivasjon[rediger | rediger kilde]

Hvis en funksjon er definert implisitt ved en ligning

- ,

så følger det av den generaliserte kjerneregelen for funksjoner av flere variabler at

I denne ligningen er

partiell deriverte av funksjonen . Forutsatt at den partiell deriverte er ulik null, så kan den deriverte av funksjonen uttrykkes som en brøk:

Eksempel[rediger | rediger kilde]

Gitt funksjonen

Den deriverte er da gitt som følger:

Det første leddet er derivert ved å bruke regelen for en potensfunksjon. Det andre leddet er håndtert ved hjelp av kjerneregelen samt regler for derivasjon av trigonometriske funksjoner og potensfunksjoner. Derivasjon av det tredje leddet er gjennomført ved å bruke produktregelen.

Egenskaper til deriverbare funksjoner[rediger | rediger kilde]

Derivasjon og kontinuitet[rediger | rediger kilde]

En funksjon som er deriverbar for , er også kontinuerlig i . En funksjon kan altså ikke være deriverbar i en diskontinuitet.

Omvendt kan en funksjon være kontinuerlig i et punkt, uten å være deriverbar i punktet. Et eksempel på dette er punktet for absoluttverdi-funksjonen.

Dersom funksjonen har en derivert som også er kontinuerlig, sies funksjonen å være kontinuerlig deriverbar. Hvis den n-te ordens deriverte eksisterer og er kontinuerlig, så er funksjonen n ganger kontinuerlig deriverbar. Klassen av slike funksjoner er viktig nok til å ha fått sitt eget symbol:

betegner klassen av funksjoner som er n ganger kontinuerlig deriverbar på definisjonsmengden . Klassen av kontinuerlige funksjoner er . En funksjon som er uendelig mange ganger kontinuerlig deriverbar kalles en glatt funksjon, og klassen av slike funksjoner betegnes som .

Generelt gjelder at

- .

Middelverdisetningen[rediger | rediger kilde]

For en funksjon som er deriverbar i et intervall, vil stigningen til sekanten mellom to vilkårlige punkt på grafen til funksjonen være et uttrykk for den midlere endringen til funksjonen mellom de to punktene. Middelverdisetningen uttrykker at grafen til funksjonen mellom de to punktene må ha en tangent med samme stigning som sekanten. Setningen kalles også sekantsetningen:

La være en funksjon som er kontinuerlig på et lukket intervall (med ). Anta videre at er deriverbar i det åpne intervallet . Da finnes minst ett punkt , slik at

- .

Dersom , medfører dette at funksjonen må ha en derivert mellom og som er lik null, det vil si at tangenten er horisontal. Dette spesialtilfellet av middelverdisetningen kalles Rolles sats.

Monotonisitet[rediger | rediger kilde]

En funksjon er monoton i et intervall dersom den er voksende eller minkende i hele intervallet. Tilsvarende sier en også at funksjonen er strengt monoton i et intervall dersom den er strengt voksende eller strengt minkende i hele intervallet. Disse egenskapene følger direkte fra middelverdisetningen.

En deriverbar funksjon er voksende i et intervall dersom den deriverte av funksjonen er ikke-negativ i hele intervallet. Tilsvarende er funksjonen minkende i et intervall dersom den deriverte er ikke-positiv i intervallet.

En deriverbar funksjon er strengt voksende i et intervall dersom den deriverte av funksjonen er positiv i hele intervallet. Tilsvarende er funksjonen strengt minkende i et intervall dersom den deriverte er negativ i intervallet.

Ekstremalverdier og vendepunkt[rediger | rediger kilde]

Dersom en funksjon er deriverbar i et punkt , så er et nødvendig vilkår for at funksjonen skal ha et ekstremalpunkt for dette argumentet. Et punkt der den deriverte er lik null kalles et stasjonært punkt.[8] Sammen med punkt der funksjonen ikke er deriverbar og eventuelle endepunkt for et definisjonsintervall, kalles dette også kritiske punkt. Et ekstremalpunkt må alltid være et kritisk punkt.[9] Et terassepunkt er et stasjonært punkt der den deriverte ikke skifter fortegn.[10]

For et punkt der en funksjon er deriverbar vil hver av de to følgende testene gi tilstrekkelige vilkår for at punktet er et maksimumspunkt:

- er et lokalt strengt maksimumspunkt dersom og den deriverte skifter fortegn fra positiv til negativ når vokser gjennom .

- er et lokalt strengt maksimumspunkt dersom og .

Tilsvarende har en for et minimumspunkt:

- er et lokalt strengt minimumspunkt dersom og den deriverte skifter fortegn fra negativ til positiv når vokser gjennom .

- er et lokalt strengt minimumspunkt dersom og .

Kartlegging av ekstremalpunkt inngår som en viktig del av funksjonsdrøfting.

Krumning og vendepunkt[rediger | rediger kilde]

En funksjon er konveks i et intervall dersom en rett linje mellom to vilkårlige punkt i intervallet ligger over grafen til funksjonen i intervallet. Dette kan også uttrykkes som at grafen til funksjonen vender den hule siden oppover eller krummer opp. Funksjonen er strengt konveks dersom grafen ligger helt under den rette linjen. Tilsvarende kan en definere at funksjonen er konkav, dersom den vender den hule siden nedover eller krummer ned.

En deriverbar funksjon er konveks eller krummer opp i et intervall dersom den deriverte er voksende i intervallet. En funksjon som er to ganger deriverbar, er strengt konveks i et intervall dersom den dobbelt-deriverte er positiv i intervallet. Den dobbelt-deriverte kan også være lik null i isolerte punkt i intervallet.

Funksjonen har dobbelt-derivert . Funksjonen er altså strengt konveks i hele .

I differensialgeometri er krumningen til en funksjon gitt ved det følgende uttrykket:[11]

Et vendepunkt er et stasjonært punkt der funksjonen skifter krumning, fra opp til ned eller omvendt. Dette vil være tilfelle dersom den dobbelt-deriverte skifter fortegn i punktet.

Funksjonen har dobbelt-derivert . Funksjonen har altså et vendepunkt i .

Taylorrekker[rediger | rediger kilde]

Taylors teorem sier at en funksjon som er () ganger kontinuerlig deriverbar på et intervall , kan tilnærmes med et polynom i intervallet, og teoremet gir også et uttrykk for feilen i denne tilnærmingen. Dersom er et vilkårlig punkt i intervallet, så er

Her er taylorpolynomet av grad :

- .

Restleddet kan uttrykkes på flere forskjellige måter, og Joseph Louis Lagranges form er gitt som[12]

- .

Argumentet er en verdi mellom og . Når svarer Taylors formel til middelverdisetningen.

I mange praktske anvendelser brukes tilnærmingen , og restleddet er da et uttrykk for feilen i tilnærmingen. Feilen vil typisk vokse når fjerner seg fra verdien .

For en glatt funksjon kan en i noen tilfeller vise at funksjonen kan uttrykkes som en uendelig konvergent taylorrekke:

Denne sammenhengen gjelder imidlertid ikke for alle glatte funksjoner. En glatt funksjon som samsvarer lokalt med sin egen taylorrekke, kalles en analytisk funksjon.[13]

Analysens fundamentalteorem[rediger | rediger kilde]

Analysens fundamentalteorem uttrykker en sammenheng mellom derivasjon og integrasjon.[14]

Hvis er en integrerbar funksjon, så er funksjonen

kontinuerlig i intervallet . Hvis er deriverbar i , så er også deriverbar i dette punktet, og .

Teoremet gir en bruksanvisning for kunne integrere en funksjon , omtalt som integranden. Dersom den antideriverte til integranden kan bestemmes som , så er

- .

Derivasjon av en kompleks funksjon av én variabel[rediger | rediger kilde]

Formell definisjon[rediger | rediger kilde]

Definisjonen av en kompleks funksjon er i notasjon lik definisjonen for en reell funksjon:

- .

Forskjellen ligger i definisjonen av grenseverdien, som nå er definert i det komplekse planet. Den komplekse størrelsen skal nå kunne nærme seg null langs en vilkårlig rute i det kompekse planet. Dette gjør at definisjonen av deriverbarhet for komplekse funksjoner er et strengere krav enn deriverbarhet for reelle funksjoner. Realdelen og imaginærdelen av en kompleks funksjon kan hver for seg være deriverbare, uten at den komplekse funksjonen er deriverbar.

En kompleks funksjon kan være deriverbar i et punkt, uten å være deriverbar i andre nærliggende punkt. En kompleks funksjon sies å være en analytisk funksjon i et punkt dersom funksjonen er deriverbar i en omegn om punktet. Begrepet holomorf funksjon er synonymt med analytisk funksjon. En funksjon som er analytisk i hele det komplekse planet, kalles en hel funksjon.

Cauchy-Riemann-ligningene[rediger | rediger kilde]

En kompleks funksjon kan generelt skrives på formen

der er den imaginære enheten, med egenskapen . De to funksjonene og er reelle funksjoner. Hvis funksjonen er deriverbar, så er også de to Cauchy-Riemann-ligningene oppfylte. Dette er to differensialligninger på formen

Ligningene er oppkalt etter Augustin Louis Cauchy og Bernhard Riemann. Den deriverte er gitt ved

Omvendt gjelder at dersom de to funksjonene og har kontinuerlige deriverte med hensyn på begge variablene, og de deriverte oppfyller Cauchy-Riemann-ligningene, så er funksjonen deriverbar.

Eksempler[rediger | rediger kilde]

Den komplekse eksponentialfunksjonen kan defineres ved

De to funksjonene

har begge kontinuerlige deriverte og oppfyller Cauchy-Riemann-ligningene. Da følger det at

Også den komplekse eksponentialfunksjonen er lik sin egen derivert. Eksponentialfunksjonen er en hel funksjon. Siden de trigonometriske funksjonene og kan defineres som lineærkombinasjonar av den komplekse eksponentialfunksjonen, er også disse to funksjonene hele. Alle polynomfunksjoner er hele funksjoner.

Den komplekse funksjonen er deriverbar kun for argumentet .

Generalisering til andre typer funksjoner[rediger | rediger kilde]

Flere typer deriverte kan defineres for funksjoner, også for funksjonstyper der argumentet ikke er et reelt eller et komplekst tall.

Retningsderivasjon for skalarfelt[rediger | rediger kilde]

Et skalarfelt er en reell funksjon av flere variable, på formen

Argumentet er her en n-dimensjonal vektor.

For et skalarfelt kan en definere den retningsderiverte i retningen ved[15]

forutsatt at grenseverdien eksisterer. Det er ikke krav at vektoren skal ha lengde lik én. Eksistens av en retningsderivert er ikke tilstrekkelig for at funksjonen skal være kontinuerlig.

Den retningsderiverte oppfyller et middelverditeorem, tilsvarende en funksjon av én variabel: Dersom den retningsderiverte eksisterer for alle verdier av i intervallet , så er

Partiell derivasjon[rediger | rediger kilde]

Utdypende artikkel: Partiellderivert

For et skalarfelt er den partiellderiverte det samme som den retningsderivert langs en av akseretningene, gitt at retningsvektoren har lengde én. Vanligvis uttrykkes definisjonen av den partiellderiverte med hensyn på variabelen på formen

- ,

forutstatt at grenseverdien eksisterer. Et skalarfelt med definisjonsmengde i kan ha partiellderiverte.

For en funksjon kan en bruke flere typer notasjon for partiellderiverte:

De partiellderiverte uttrykker endringene i funksjonen i hver av retningene parallelt med aksene. Dersom representerer variasjonen i temperatur i et rom, så er et mål for temperaturendringen i -retningen.

Gradienten til en funksjon er en vektor sammensatt av alle partiellderiverte. For uttrykkes gradienten som

Denne vektoren vil peke i retningen der funksjonen endrer seg mest. Dersom gradienten er definert, så er den retningsderiverte i retningen gitt ved

Også for partiellderiverte kan en definere høyere-ordens deriverte, i alle kombinasjoner, for eksempel

Hessematrisen er en matrise av alle de andre-ordens partiell deriverte til et skalarfelt. Ekstremalverdier for et skalarfelt kan studeres ved hjelp av gradienten og hessematrisen.

Et tilstrekkelig vilkår for at de to partiell deriverte og skal være like i et punkt, er at begge eksisterer og er kontinuerlige i punktet.[16]

Derivasjon for vektorfelt[rediger | rediger kilde]

Et vektorfelt er en funksjon der både argument og funksjonsverdi er vektorer:

For hver av komponentene i funksjonsverdien kan en definere partiellderiverte:

Jacobimatrisen til et vektorfelt er en -matrise der elementene er første-ordens partiellderiverte:

For vektorfelt kan en også definere total derivasjon.

Total derivasjon[rediger | rediger kilde]

Den totalderiverte til et generelt vektorfelt er en transformasjon som lokalt er den beste lineære tilnærmingen til funksjonen.

En funksjon , hvor er en åpen mengde i kalles totalt deriverbar eller totalderiverbar i punktet , hvis det finnes en lineær avbildning slik at

- .

Hvis en slik lineær avbildning eksisterer, er den entydig bestemt og avhenger ikke av hvilken norm som benyttes.

For svarer den totalderiverte til den ordinære deriverte av en reell funksjon. For et skalarfelt er , og den totalderiverte er lik gradienten til funksjonen. For et vektorfelt er jacobimatrisen en representasjon av den lineære transformasjonen.

En funksjon som er totalderiverbar i et punkt, vil være kontinuerlig i punktet.

Hvis den totalderiverte eksisterer i et punkt, så eksisterer også alle de partiellderiverte i punktet. Omvendt vil ikke eksistensen til samtlige partiell deriverte i et punkt garantere at den totalt deriverte eksisterer i punktet. Er de partiellderiverte definert og kontinuerlige i en omegn om , så er funksjonen totalderiverbar i .

Anvendelser[rediger | rediger kilde]

Beskrivelse av endringer[rediger | rediger kilde]

Derivasjon blir brukt i mange matematiske modeller der en må beskrive endringer av en eller annen type. Typisk vil en endring av en størrelse over tid kunne uttrykkes som den deriverte eller en partiell derivert . En endring i størrelsen i rommet kan tilsvarende beskrives som en partiell derivert med hensyn på en romlig koordinat eller en gradient.

Den førstederiverte til en strekning etter tiden representerer en skalar hastighet, mens den andrederiverte er et uttrykk for akselerasjonen. I det tredimensjonale rommet er den deriverte a posisjonsvektoren lik den vektorielle hastigheten.

Vinkelhastigheten er definert som den tidsderiverte av en rotasjonsvinkel, og vinkelakselerasjonen er den andrederiverte.

Differensialligninger[rediger | rediger kilde]

Utdypende artikkel: Differensialligning

En differensialligning er en ligning som kombinerer deriverte av en funksjon med funksjonen selv samt koeffisienter der den uavhengige variabelen inngår. Et eksempel er differensialligningen

Den ukjente i en differensialligning er en funksjon. Ligningen over har løsningen

- ,

der og er vilkårlige konstanter.

Dersom den ukjente er en funksjon av én variabel, sies ligningen å være en ordinær differensialligning. En partiell differensialligning inneholder partiellderiverte, og den ukjente er en funksjon av flere variable.

Newtons bevegelseslov kan gi opphav til mange differensialligninger. Loven kombinerer kraft , masse og akselerasjon :

Dersom kraften for eksempel kan uttrykkes som en funksjon av posisjonen , så leder dette til en differensialligning for posisjonen.

Et eksempel fra økonomi[rediger | rediger kilde]

I mikroøkonomi kan en analysere forskjellige former for produksjonsfunksjoner, for å skape forståelse for makroøkonomiske sammenhenger. Det er først og fremst den typiske oppførselen til en produksjonsfunksjon som er av interesse: Hvordan reagerer de avhengige variablene (for eksempel den mengden av en vare som produseres) når (for eksempel arbeid eller kapital) økes med en (infinitesimal) enhet.

En grunntype av produksjonsfunksjoner er den nyklassiske produksjonsfunksjonen. Denne funksjonen har egenskapen at produksjonen stiger når argumentet øker, samtidig som at økningen avtar når argumentet vokser. For eksempel kan man ha den følgende produksjonsfunksjonen for en virksomhet:

Den deriverte følger av kjerneregelen:

- .

Da rotuttrykket alltid er positivt, vil produksjonen øke med økende innverdi. Den andrederiverte er gitt ved

- .

Denne er alltid negativ, så økningen er synkende.

Historie[rediger | rediger kilde]

Problemstillingen som differensialregningen betrakter, var kjent som tangentproblemet helt siden antikken. Den nærliggende løsningen var å approksimere tangenten ved hjelp av sekanter over et positivt, men vilkårlig lite intervall. Den tekniske vanskeligheten bestod av å regne med slike infinitesimalt små intervallengder. Pierre de Fermat løste rundt 1640 tangentproblemer for polynomer. Her beskrev han den deriverte, men uten å betrakte grenseverdier, og uten å forklare hva den matematiske rettferdiggjøringen for fremgangsmåten hans var. På samme tid valgte Descartes en algebraisk fremgangsmåte, hvor han anbrakte en sirkel nær kurven. Her vil sirkelen skjære kurven i to punkter, med mindre sirkelen og kurven tangerer hverandre. Da var det mulig å bestemme stigningen til tangenten for visse kurver.

På slutten av 1600-tallet lyktes det Isaac Newton og Gottfried Wilhelm Leibniz uavhengig av hverandre å utvikle fungerende fremgangsmåter uten selvmotsigelser. Newton og Leibniz angrep problemet fra forskjellige vinkler. Mens Newton nærmet seg problemet via momentanhastighetsproblemet, prøvde Leibniz å løse det geometrisk ved hjelp av tangentproblemet. Arbeidene deres tillot en abstraksjon fra den rent geometriske beskrivelsen, og regnes derfor som begynnelsen av matematisk analyse. De ble først og fremst kjent gjennom boka til adelsmannen Guillaume François Antoine, marquis de L'Hôpital, som fikk privatundervisning av Johann Bernoulli og publiserte dennes forskning innen analyse. De derivasjonsreglene som er best kjent i dag, er først og fremst basert på verkene til Leonhard Euler, som satte sitt preg på funksjonsbegrepet. Newton og Leibniz arbeidet med vilkårlig små tall, men som er større enn null. Dette ble kritisert av samtidige som ulogisk, eksempelvis av biskop Berkeley i det polemiske skriftet The analyst: or a discourse addressed to an infidel mathematician. Differensialregningen ble likevel, tross den herskende usikkerheten, konsekvent videreutviklet, i første rekke på grunn av de tallrike anvendelsene i fysikk og andre områder av matematikken. Symptomatisk for den tiden var prisutskrivningen til Det prøyssiske vitenskapsakademiet i 1784:

… Den høyere geometri benytter ofte uendelig store og uendelig små størrelser; imidlertid har de gamle lærde omhyggelig unngått det uendelige, og enkelte berømte analytikere i vår tid bekjenner at begrepene er selvmotsigende. Akademiet forlanger altså at man forklarer hvordan så mange sanne satser kan oppstå av en selvmotsigende antagelse, og at man angir et sikkert og klart grunnbegrep som kan erstatte det uendelige, uten å gjøre utregningene for vanskelige eller lange …

Først på begynnelsen av 1800-tallet lyktes det Augustin Louis Cauchy å gi differensialregningen den logiske stringensen vi er vant til i dag, i det han gikk bort fra de infinitesimale størrelsene og definerte den deriverte som grenseverdien til stigningen av sekantene. Den definisjonen av grenseverdier som brukes i dag ble formulert av Karl Weierstraß på slutten av 1800-tallet.

Se også[rediger | rediger kilde]

Referanser[rediger | rediger kilde]

- ^ R. Tambs Lyche (1961). Matematisk Analyse, Bind I. Oslo: Gyldendal Norsk Forlag.

- ^ F. Cajori: A history of mathematical notations Bind II, s.204

- ^ F. Cajori: A history of mathematical notations Bind II, s.207

- ^ F. Cajori: A history of mathematical notations Bind II, s.197

- ^ D.J. Struik (1961). Lectures on classical differential geometry. New York: Dover Publications. s. 6. ISBN 0-486-65609-8.

- ^ F. Cajori: A history of mathematical notations Bind II, s.213

- ^ F. Cajori: A history of mathematical notations Bind II, s.208-209

- ^ E.J.Borowski, J.M.Borwein: Dictionary of mathematics s.558

- ^ T. Lindstrøm: Kalkulus s.246

- ^ «Kompendium, Mat 1050» (PDF). Arne B. Sletsjøe, UiB. Besøkt 23. januar 2021.

- ^ R. Tambs Lyche (1961). Matematisk Analyse, Bind I. Oslo: Gyldendal Norsk Forlag.

- ^ : G. Thomas, R. Finney; Calculus and Analytic Geometry s.795

- ^ E.J.Borowski, J.M.Borwein: Dictionary of mathematics s.16

- ^ T. Lindstrøm: Kalkulus s.331

- ^ T.M. Apostol: Calculus , Bind II s.252ff

- ^ T.M. Apostol: Calculus , Bind II s.277

Litteratur[rediger | rediger kilde]

T.M. Apostol (1969). Calculus. II. New York: John Wiley & Sons. ISBN 0-471-00008-6.

- E.J.Borowski, J.M.Borwein (1989). Dictionary of mathematics. Glasgow: Collins. ISBN 0-00-434347-6.

- T. Lindstrøm (2006). Kalkulus (norsk). Universitetsforlaget. ISBN 978-82-15-00977-3. Besøkt 30. august 2016.

- S.B. Lindström (2013). Matematisk ordbok för högskolan: engelsk-svensk, svensk-engelsk: (svensk). Stefan B. Lindström. ISBN 978-91-981287-0-3. Besøkt 30. august 2016.

- G. Thomas, R. Finney (1995). Calculus and Analytic Geometry (5th edition utg.). Reading, USA: Addison-Wesley. ISBN 0-201-53174-7.

- R.V Churchill, J.W. Brown, R.F. Verhey (1974). Complex variables and applications (english). Tokyo: McGraw-Hill Kogakusha. ISBN 0-07-010855-2.

- Florian Cajori (2007). A history of mathematical notations. I og II. Princeton, USA: Cosimo. ISBN 978-1-60206-684-7.

![{\displaystyle {\begin{alignedat}{2}\lim _{x\nearrow 0}{\frac {f(x)-f(0)}{x-0}}\ &=\ \lim _{x\nearrow 0}{\frac {-x-0}{x-0}}\ &&=\ -1\\[5pt]\lim _{x\searrow 0}{\frac {f(x)-f(0)}{x-0}}\ &=\ \lim _{x\searrow 0}{\frac {x-0}{x-0}}\ &&=\ 1\end{alignedat}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/9affd8dea2b0b3eb8972f48f00e9623c39175df7)

![{\displaystyle {\begin{alignedat}{2}f&=c\cdot k^{u}\cdot l^{v}\cdot m^{w}\cdot ...\\[5pt]f'&=f\cdot ({\frac {u}{k}}\cdot k'+{\frac {v}{l}}\cdot l'+{\frac {w}{m}}\cdot m'+...)\end{alignedat}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/596895f401c9b766afbd3618a4aaefdad45e0358)

![{\displaystyle f:[a,b]\to \mathbb {R} }](https://wikimedia.org/api/rest_v1/media/math/render/svg/b592d102ccd1ba134d401c5b3ea177baaba3ffac)

![{\displaystyle [a,b]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/9c4b788fc5c637e26ee98b45f89a5c08c85f7935)

![{\displaystyle F(x)=\int _{a}^{x}f(t)\,\mathrm {d} t\qquad x\in [a,b]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d7088f0be513eb8106dd9c5dc1f1e4299035b97a)

![{\displaystyle [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/738f7d23bb2d9642bab520020873cccbef49768d)