Informasjonsteori

Informasjonsteori er en matematisk teori som tar utgangspunkt i matematisk statistikk og sannsynlighetsteori for å beskrive overføring (kommunikasjon) av informasjon i tekniske systemer. Informasjonsteorien ble grunnlagt i 1948 av matematikeren Claude Shannon[1].

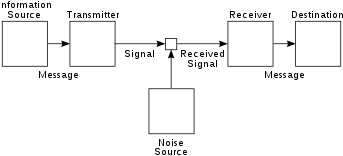

Informasjonsteorien oppsto innen ingeniørmiljøer som forsket på tekniske kommunikasjonssystemer som telefon og telegraf, hvor det er viktig at opplysningene som mottas er de samme som ble sendt ut fra avsender. Shannon, i tillegg til å gi en matematisk definisjon av informasjon, klarte å gi øvre grenser for hvor mye informasjon som er mulig å sende over støyfrie og støyete kanaler. Shannons pionerarbeide har vært svært viktig for de senere fremskrittene i informasjons- og kommunikasjonsteknologien.

Enkel beskrivelse med ord av informasjonsteori[rediger | rediger kilde]

Blant de viktigste begreper i informasjonsteori er[2]:

- Måltall for informasjonsmengde

- kapasiteten til en informasjonskanal

- koding av informasjon

- overføringsnøyaktigheten (under påvirkning av f. eks. "støy" eller tilfeldige forstyrrelser på kommunikasjonslinjen

Informasjon skal her forstås som meddelelser, opplysninger eller bare symbolrekker (som f. eks bokstavene i en setning). Som mål for informasjonsmengde brukes enheten bit (av "binary digit"). I enkle tilfeller kan man klare seg med å definere informasjonsmengde som det (minste) antall spørsmål av "ja eller nei" typen, som er nødvendig for fullstendig å klarlegge de muligheter som foreligger[3].

Om informasjonsmengden en kilde tilskrives brukes bokstaven H. H er et tall som kan betraktes som det gjennomsnittlige antall bits i et budskap. H kalles også for informasjonskildens entropi. Entropibegrepet kan brukes til kompliserte situasjoner. et realistisk tilfelle er en informasjonskilde som lik telegrafien lager budskaper i form av rekker med symboler tatt ut av et fast "alfabet" av symboler. Noen symboler vil være mer hyppige enn andre. Entropien H kan betraktes som det gjennomsnittlige antall bits kilden frembringer per symbol i sitt alfabet.[2]

Når en informasjonskilde sender budskaper inn i en kommunikasjonskanal kalles kanalens kapasitet for C. C er et måltall som avhenger av hvor lang tid det går med til å sende forskjellige symboler i kanalens "alfabet" og hvilke innskrenkninger som finnes i rekkefølgen symbolene kan sendes i. Kapasiteten C uttrykker det antall bits av den informasjonsmengden som kanalen ved ideell utnyttelse er i stand til å overføre per sekund.[2]

Når en gitt informasjonskilde skal sende meddelelser over en gitt kanal, må disse meddelelsene innkodes før de innføres på kanalen. Forskjellige innkodingssystemer kan brukes. Hvert innkodingssystem gir en bestemt verdi for hastigheten x. Hastigheten x er det gjennomsnittlige antall symboler fra kilden overført per. sekund. Utfordringen er da å utforme et innkodingskjema som forbinder kildens statistiske egenskaper med kanalens karakteristika på en slik måte at x blir så stor som mulig; at overføringshastigheten blir maksimal. Hastigheten x kan bringes så tett til forholdet C/H man vil ved utforming og valg av innkodingsskjema. Forholdet C/H kan ikke overstiges og er den maksimalt oppnåelige grense ved kombinasjon av kilde med kanal.[2]

Informasjonsteorien kan også behandle kanaler med støy og kilder som transmitterer kontinuerlig informasjon (i stedet for diskrete impulser).[2]

Matematisk[rediger | rediger kilde]

En tilfeldig variabel X med n mulige utfall {x1, ..., xn}, Shannon entropien, er et mål på usikkerhet og kalles H(X), er definert som

(1)

hvor p(xi) er sannsynlighetsfunksjon av utfallet til xi.

Se også[rediger | rediger kilde]

Referanser[rediger | rediger kilde]

- ^ Shannon, Claude E. (1948). «A Mathematical Theory of Communication». Bell System Technical Journal July/October 1948. 27 (3): 379–423. (PDF)

- ^ a b c d e William Karush: Matematisk oppslagsbok. Schibsted 1982. ISBN 82 516 0832 5 side 44-45

- ^ William Karush: Matematisk oppslagsbok. Schibsted 1982. ISBN 82 516 0832 5 side 44-45